Python数据分析:高效技巧与实践策略深度揭秘

|

大家好,我是区块链矿工,一个常年和算力、数据打交道的人。每天面对成吨的链上数据,我深知,没有一套高效的数据分析方法,根本无法从海量信息中提炼出有价值的内容。 Python,作为我日常分析的主力工具,已经成为我挖矿路上不可或缺的“镐头”。它简洁的语法、强大的库支持,让我在处理交易数据、区块信息、钱包地址分布时,效率提升了不止一个档次。 数据清洗是分析的第一步。很多时候,链上数据并不干净,比如时间戳格式不统一、字段缺失、数值异常等。我常用pandas处理这些问题,比如用`fillna()`填充缺失值,用`astype()`转换数据类型,用`drop_duplicates()`去重。这些操作看似简单,但却是后续分析的基石。

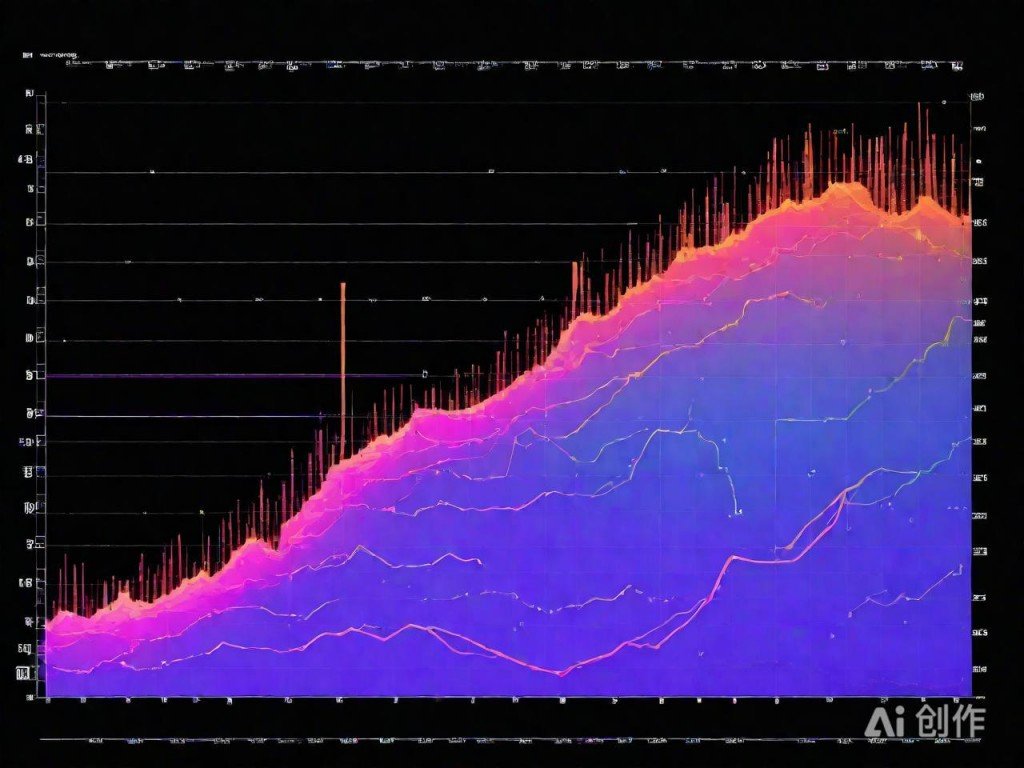

2025规划图AI提供,仅供参考 分析链上行为时,我特别依赖时间序列处理。Python的`datetime`模块配合pandas的`resample()`函数,能轻松将交易按小时、天、周聚合,观察流量高峰、转账频率变化。这种时间维度的洞察,对判断市场行为、节点活跃度非常有帮助。可视化是讲故事的关键。我常使用matplotlib和seaborn将数据“画”出来。例如,绘制交易量随时间变化的折线图、钱包地址增长的柱状图、节点分布的热力图。一张清晰的图表,胜过千言万语,尤其在向团队或投资人汇报时,效果显著。 当然,我也喜欢用NumPy进行底层计算优化。在处理大量哈希值比对、地址生成、签名验证时,NumPy的数组运算能力比原生Python快得多。特别是在批量处理区块头信息时,利用向量化操作代替循环,性能提升明显。 为了更高效地挖掘数据价值,我还结合了Dask和Vaex处理超大文件。当数据量超过内存限制时,这些库能像矿机一样,一边读取一边计算,不卡顿、不崩溃,特别适合处理历史区块全量数据。 最让我兴奋的是,Python生态中还有像Plotly、Dash这样的交互式分析工具。我可以用它们搭建一个实时监控仪表盘,追踪矿工出块情况、Gas费波动、链上大额转账等关键指标,真正实现“边挖矿边看数据”。 总结一下,Python数据分析的核心在于“灵活+高效”。无论是数据清洗、统计分析,还是可视化展示,Python都能提供成熟的解决方案。作为区块链矿工,我强烈建议每一位数据爱好者,深入掌握Python的实战技巧,你会发现,数据不仅能帮你挖矿,更能帮你看清链上的每一个真相。 (编辑:92站长网) 【声明】本站内容均来自网络,其相关言论仅代表作者个人观点,不代表本站立场。若无意侵犯到您的权利,请及时与联系站长删除相关内容! |